CVPR 2015 Webpage

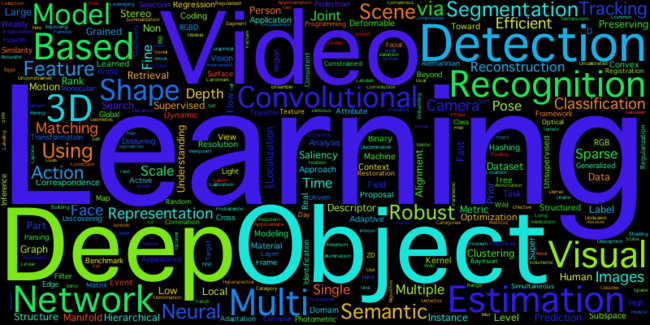

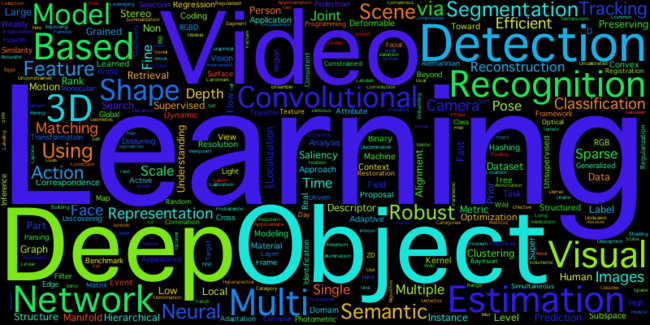

CVPR2015のProgramがアナウンスされているみたいなので、論文のタイトルをスクレイピングしてWord Cloudを作ってみました。

論文のタイトルはpupを使って取得しました。Oralの発表者がPosterも発表するケースもあるようなので、sortとuniqも入れてます。

$ curl -s http://www.pamitc.org/cvpr15/program.php | pup 'td > b:first-child' text{} | sort | uniq > cvpr2015papers.txt

pupの書き方についてはこちらを参考にしました。

mattn.kaoriya.net

pythonのWordCloudライブラリを使って作成します。最初に作ったWord Cloudは真ん中にでかく"Image"となっていたので、一つだけstopwordsに追加しています。

import os

from wordcloud import WordCloud, STOPWORDS

import matplotlib.pyplot as plt

def main():

d = os.path.dirname(__file__)

DOC_NAME = "cvpr2015papers.txt"

text = open(os.path.join(d, DOC_NAME)).read()

stopwords = STOPWORDS.copy()

stopwords.add("image")

wc = WordCloud(max_words=300, stopwords=stopwords, width=800, height=400)

wc.generate(text)

wc.to_file(os.path.join(d, "cvpr2015wordcloud.png"))

plt.imshow(wc)

plt.axis("off")

plt.show()

if __name__ == "__main__":

main()

WordCloudを使う時は、FONT_PATHを設定しておく必要があります。

$ export FONT_PATH=/Library/Fonts/Osaka.ttf

出来た画像はこのような感じです。

Word Cloudを眺める

まずDeepですが、Deepを含むタイトル数を調べてみると、

$ cat cvpr2015papers.txt | grep -i "deep" | wc -l

57

全体が602件なので約10%がDeepを含んでいることになります。NeuralやNetwork, Convolutionalも大きく表示されていて、2015年も引き続きDeep Learning系は多そうですね。

それから、Videoも大きく表示されています。

$ cat cvpr2015papers.txt | grep -i video | wc -l

47

Action RecogntionやEvent Detection、Video ClassificationをDeep Networkでというタイトルになっているものもあって、SingleフレームからMultipleフレームへもDeep Learningが対象を広げているのでしょうね。

3Dも同じ流れかも。

$ cat cvpr2015papers.txt | grep -i 3D | wc -l

37

細かい所を見るともっと色々な視点で見れそうですが、Deep系はまだまだHotなTopicであることは間違いなさそうです。

参考

一応、使ったテキストファイルとスクリプトはgithubにあげておきました。

github.com