論文まとめ:Temporal Chain of Thought: Long-Video Understanding by Thinking in Frames

aistudioでGeminiと対話しながら、表題の論文をまとめました。(個人的に、NotebookLMよりもaistudioの方がUIが好みです)

この論文はどんなもの?

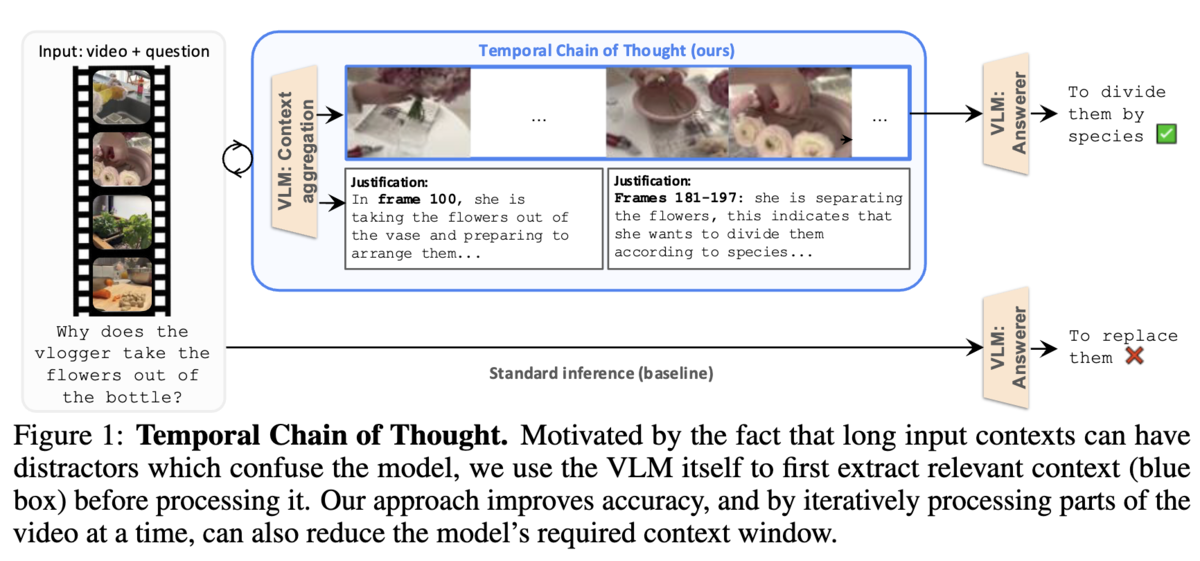

- 長時間動画を対象としたVLMの推論能力向上を目指し、新たな推論戦略「Temporal Chain of Thought (TCoT)」を提案

- 動画の質問応答タスクを「関連フレームの抽出」と「抽出フレームに基づく回答生成」の2段階に分解し、VLM自身にプロンプティングを通じて思考の連鎖を実行させることで、無関係なコンテキストによる性能劣化を抑制

- 注目すべきは、このアプローチにより、より短いコンテキスト長のVLMが、700Kトークンもの広大なコンテキストを持つモデルを凌駕する性能を達成した点であり、これはモデルの物理的なコンテキスト長以上に、推論戦略そのものが性能を左右することを示唆している

既存研究の課題

この論文が解決しようとする課題は、主に以下の二点に集約される。

- 長コンテキストVLMの課題

- 最新のVLMは数百から数千フレームもの入力を処理できますが、多くの研究(例えばLost in the middle)で示されているように、コンテキストが長くなるにつれて、モデルが無関係または誤解を招く内容に圧倒され、結果として精度が飽和、あるいは低下する

- 複数のモデルを組み合わせる手法の課題

- 複数の専用モデルを組み合わせる従来の手法(例えばVideoAgent)は、ビデオをキャプションなどのテキスト中間表現に変換する際に情報が失われる上、多段なパイプライン構成によりシステムが複雑化し、各段階でのエラーが伝播・蓄積しやすい

提案手法の肝は?

- CoTの時間軸への応用

- Chain of Thoughtは、入力 → 出力という直接的な思考をするのではなく、入力 → 思考プロセス → 出力のように、多段階のステップへ分解する。提案手法であるTemporal CoTでは、動画QAタスクにおける「思考プロセス」を、長大な動画から質問へ回答するための根拠となるフレームを時系列に抽出することとして設計。

- 具体的には、質問qと動画xに基づいて最も関連性の高い情報を抽出し、凝縮されたコンテキストcを作成するコンテキスト集約ステージと、凝縮コンテキストcを使って、質問qに対する最終的な回答aを生成する回答生成ステージから構成されるアーキテクチャを設計

- 分割統治にもとづくDynamic Segment TCoT

- VLMのコンテキスト長に収まらない動画に対して、時間的に重複しないセグメントに分割して並列かつ独立にコンテキストを抽出、全てのセグメントのコンテキストを統合する

- これにより、TCoTを長時間の動画にも適用することが可能となる

提案手法の有効性はどのように評価した?

- 主要ベンチマークデータセットでのSOTA評価

- LVBench, Egoschema, NEXT-QA, OpenEQAを使用

- Ablation Study

- TCoTを構成する各要素(コンテキスト集約、フレーム選択方法など)が、本当に性能向上に寄与しているのか。

- 一般化能力の評価

- TCoTが、Gemini 1.5 Flash以外のVLMでも有効に機能するか。

有効性評価により得られた結論は?

- 圧倒的な性能と汎用性

- TCoTは、平均68分の超長尺ビデオを含む4つの多様なベンチマーク全てで既存の最先端(SOTA)性能を大幅に更新。この結果は、TCoTが特定のタスクやデータに依存しない、極めて汎用性の高いアプローチであることを証明している

- 設計の正当性と効率性:

- 「VLM自身に賢くフレームを選ばせる」というTCoTの核心的な設計は、単純なサンプリングや他の代替手法よりも明らかに優れており、性能向上の直接的な要因である。また、同じ計算コストを投じた場合でも標準的な推論を上回り、計算リソースをより効率的に活用できることが示された

- モデルへの一般化能力: